Um artigo de pesquisa recente, ‘Large Language Models Orchestrating Structured Reasoning Achieve Kaggle Grandmaster Level’, apresenta o ‘Agent K v1.0’. É a primeira versão de um sistema autônomo de ponta a ponta projetado para automatizar, otimizar e generalizar diversas tarefas de ciência de dados.

O artigo afirma que grandes modelos de linguagem (LLMs) podem atingir autonomamente um nível de desempenho comparável ao Kaggle Grandmasters, uma afirmação que gerou debate na comunidade de ciência de dados.

Bojan Tunguz, quatro vezes Grande Mestre do Kaggle, acessou o LinkedIn para expressar suas opiniões sobre o mesmo.

“As afirmações do “Agente de Nível Kaggle Grandmaster” são uma besteira totalmente inqualificável.”

Ainda não é exatamente um Grande Mestre

Os pesquisadores da Arca de Noé da Huawei, do Centro de IA e Departamento de Ciência da Computação da UCL e da Universidade Técnica de Darmstadt apresentaram que o agente foi testado em uma variedade de competições Kaggle.

O Agente K afirma alcançar uma taxa de sucesso de 92,5% em diversas tarefas, apresentando capacidades em domínios tabulares, visão computacional, PNL e multimodais.

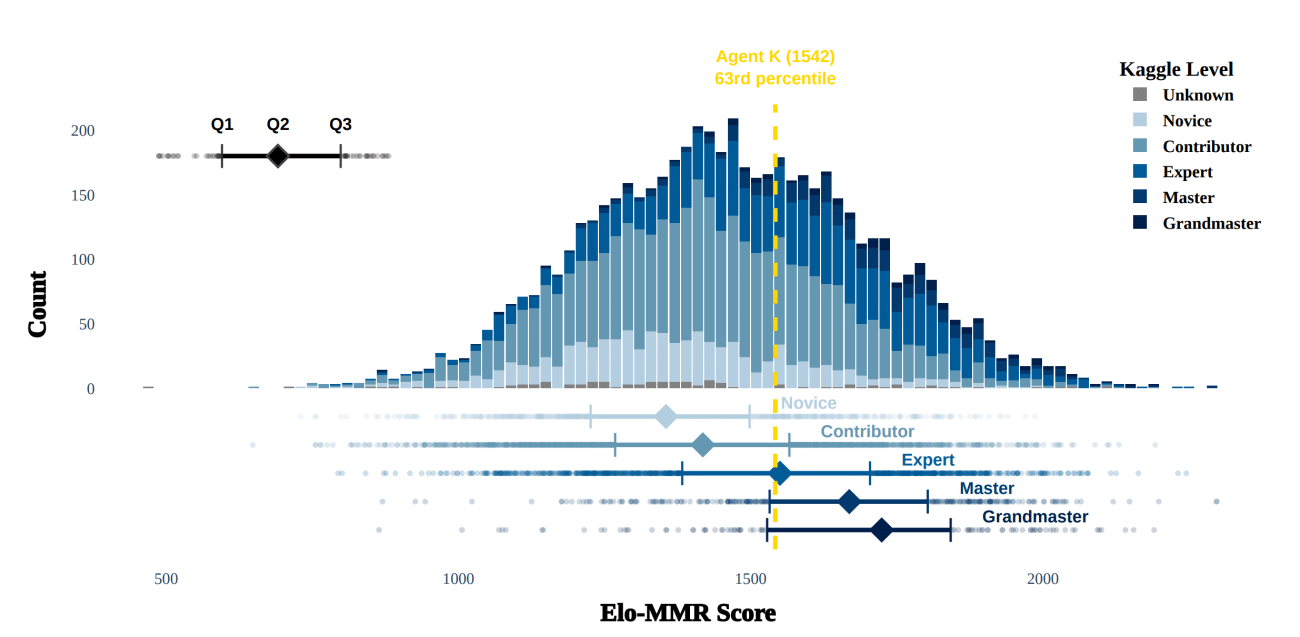

O artigo também relata que o Agente K v1.0 foi classificado entre os 38% melhores concorrentes humanos, alcançando um nível de habilidade que eles argumentam estar no mesmo nível dos usuários humanos experientes. Com altas pontuações em competições, incluindo recorde de medalhas de ouro, prata e bronze, os autores sugerem que o Agente K atingiu o nível de desempenho de um Grande Mestre.

Referindo-se a isso, um cientista de dados do X disse: “Se você estiver entre os 38% melhores participantes do Kaggle, você nem mesmo será capaz de se tornar um Especialista, muito menos um Grande Mestre”.

As competições Kaggle exigem não apenas habilidades técnicas avançadas, mas também experiência prática e uma compreensão diferenciada dos desafios da ciência de dados. Como destacado por MIRAR anteriormente, mesmo indivíduos com amplo conhecimento teórico muitas vezes consideram essas competições desafiadoras, significando a lacuna entre o aprendizado acadêmico e a aplicação prática.

Chamando o título da pesquisa de “enganoso”, Santiago Valdarrama, um cientista da computação, disse no LinkedIn que muitas das competições que usaram nem eram competições reais e que usou muitas etapas manuais e codificadas pelos autores para ajudar a orientar o modelo.

“O sistema é limitado apenas a certos tipos de problemas que se enquadram nas proteções codificadas”, acrescentou.

Além disso, no domínio da análise de dados tabulares, os modelos tradicionais de aprendizado de máquina, como o XGBoost, continuam a superar os modelos mais complexos, incluindo os LLMs. O XGBoost se destaca no tratamento de dados estruturados com eficiência e precisão, muitas vezes superando as técnicas de aprendizagem profunda neste domínio.

MIRAR havia discutido anteriormente a evolução do papel dos cientistas de dados à luz dos avanços do LLM, sugerindo que, embora os LLMs possam automatizar certas tarefas, eles ainda não podem substituir o conjunto abrangente de habilidades necessárias para competições de ciência de dados de alto nível.

Agente K conquista medalhas?

Para garantir uma análise justa, os pesquisadores compararam os resultados do Agente K com os de 5.856 competidores humanos na mesma competição. Eles acompanharam as taxas de aquisição de medalhas de ouro, prata e bronze, aplicando critérios de medalhas consistentes a ambos os grupos.

Os ajustes contabilizaram medalhas em competições onde as medalhas não foram concedidas oficialmente, permitindo uma comparação direta. As descobertas mostraram que o Agente K ganhou medalhas de forma mais consistente do que muitos usuários do Kaggle, especialmente em medalhas de bronze.

Ele alegou ter superado os participantes humanos em 42% dos casos para o bronze, em comparação com 23% onde os humanos tinham vantagem. Para medalhas de ouro, ganhou 14% das vezes contra 6% para competidores humanos.

Contudo, como salientou Tunguz, esta afirmação pode ser enganosa. Ele argumentou que os resultados do artigo exageraram a classificação do modelo, uma vez que apenas um bom desempenho em algumas competições não equivale a alcançar o status de Grande Mestre.

Alcançar um nível de Grande Mestre no Kaggle requer colocações consistentes de alto nível em vários desafios altamente competitivos, muitas vezes exigindo insights e adaptabilidade que faltam atualmente aos LLMs.

Ele também disse que a principal razão pela qual nenhum dos testes foi totalmente bem-sucedido foi que eles não foram realizados em uma competição ativa do Kaggle. A grande maioria dos conjuntos de dados utilizados eram conjuntos de dados sintéticos de brinquedos para competições em parques infantis.

Com base apenas nisso, o LLM não pode ser classificado como Nível Kaggle Grandmaster. “CADA Kaggler talentoso que conheço compartilha dessas opiniões”, disse ele.

O jornal também concorda!

Curiosamente, a seção de limitações do artigo reconhece que o desempenho do Agente K v1.0, embora promissor, não equivale inteiramente às habilidades humanas do Grande Mestre.

Sua pontuação Elo-MMR, a métrica usada para avaliar seu nível de habilidade, colocou-o abaixo da mediana dos verdadeiros Grandes Mestres. Esta é uma lacuna notável, refletindo os desafios que os LLMs ainda enfrentam em tarefas que exigem engenharia avançada de recursos, compreensão diferenciada e alta adaptabilidade.

As melhorias futuras visam aumentar essas pontuações, refinando áreas onde o agente atualmente está atrasado, potencialmente fechando a lacuna com os concorrentes humanos de elite.

Além disso, o artigo sugere que o sucesso do Agente K v1.0 se deveu em parte a otimizações específicas e feedback ambiental, em vez de uma capacidade generalizável de nível Grande Mestre.

Em última análise, embora o Agente K demonstre o potencial dos LLMs na ciência de dados competitiva, alcançar o verdadeiro status de Grande Mestre Kaggle de forma autônoma permanece fora do alcance da tecnologia de IA atual. Esse sentimento é claramente repetido por profissionais de ciência de dados que enfatizam a habilidade e a adaptabilidade necessárias para desempenhos consistentes de alto nível no Kaggle.

Esse artigo é uma releitura de: analyticsindiamag.com