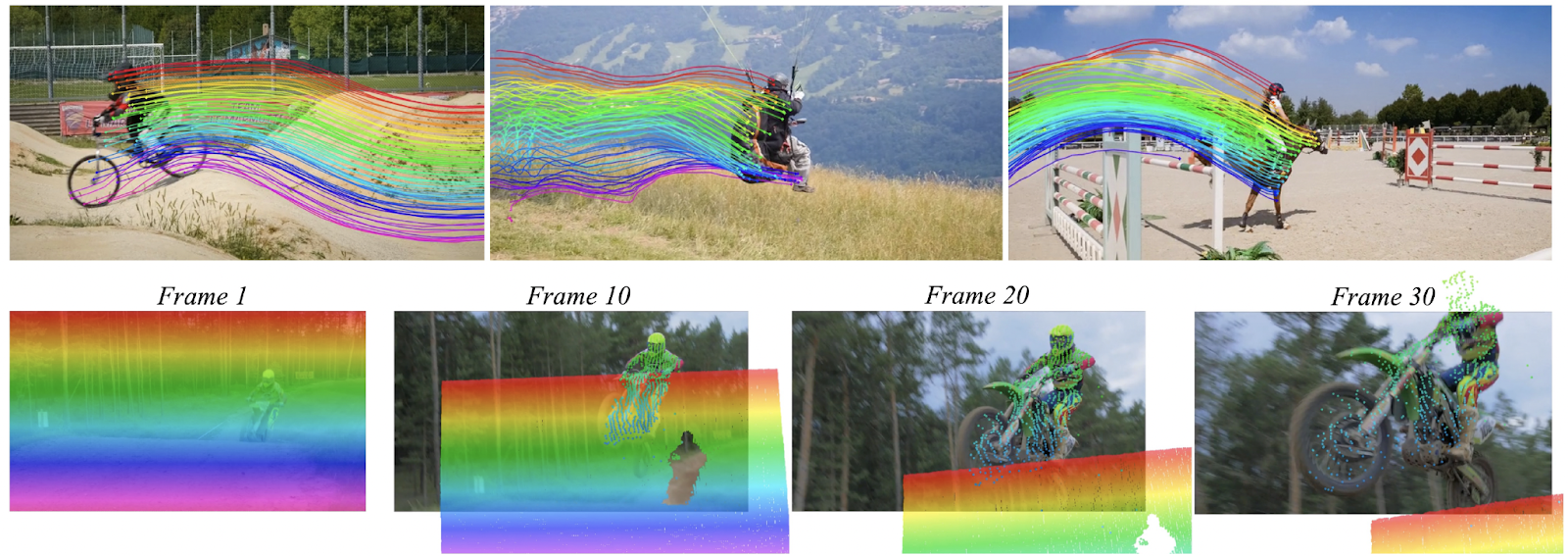

A Meta, em 16 de outubro, anunciou o lançamento do CoTracker3, um modelo de rastreador de pontos para rastrear vídeos, uma atualização de sua série de modelos CoTracker com tecnologia avançada de IA. O CoTracker3 foi projetado para lidar com situações em que os pontos rastreados ficam fora de vista ou temporariamente ocluídos para superar desafios no rastreamento de objetos em cenários complexos.

Clique aqui para conferir o repositório GitHub.

Ao introduzir um método de aprendizagem semissupervisionado chamado 'pseudo rotulagem' em vídeos reais, ele permite que o modelo autorotule partes dos dados, enquanto o Meta se concentra em aumentar a qualidade e a quantidade de informações de treinamento sem exigir conjuntos de dados totalmente anotados.

De acordo com os pesquisadores, o CoTracker3 pode superar rastreadores treinados em mais 1.000 vídeos por meio de seu protocolo de treinamento semissupervisionado simples. Ao rastrear pontos em conjunto, o CoTracker3 lida com oclusões melhor do que qualquer outro modelo, principalmente quando operado offline.

Meta disse que este modelo pode ser usado como um bloco de construção para tarefas que exigem estimativa de movimento, como rastreamento 3D, geração controlada de vídeo ou reconstrução 3D dinâmica.

Os pesquisadores também disseram que o CoTracker3 superou o que há de mais moderno no TAP-Vid e outros benchmarks, pois sua arquitetura combina várias ideias de rastreadores recentes e elimina componentes desnecessários.

Disponível em plataformas online e offline, o modelo pode ser explorado ao vivo por desenvolvedores e pesquisadores no Hugging Face. A utilidade deste modelo abrange vários domínios, como realidade aumentada, robótica e análise esportiva, onde o rastreamento preciso do movimento dos objetos é essencial.

A Meta também disponibilizou o modelo e os recursos associados sob uma licença A-NC para facilitar pesquisas futuras.

No início deste ano, a Meta também introduziu a Video Joint Embedding Predictive Architecture (V-JEPA) V-JEPA, que prevê as partes faltantes dos vídeos sem a necessidade de recriar todos os detalhes. Ele aprende com vídeos não rotulados, por isso não requer dados categorizados por humanos para começar a aprender. Isso melhora a compreensão do mundo pelas máquinas, analisando interações de vídeo entre objetos.

Esse artigo é uma releitura de: analyticsindiamag.com